Unity历史版本下载列表

Unity6系列最新版本:Unity 6000.2.0

Unity2023系列最新版本:Unity 2023.2.20

Unity2022系列最新版本:Unity 2022.3.59

Unity2021系列最新版本:Unity 2021.3.49

Unity2020系列最新版本:Unity 2020.3.48

Unity2019系列最新版本:Unity 2019.4.40

Unity2018系列最新版本:Unity 2018.4.36

Unity2017系列最新版本:Unity 2017.4.40

Unity5.x系列最新版本:Unity 5.6.7

Unity4.x系列最新版本:Unity 4.7.2

Unity3.x系列最新版本:Unity 3.5.7

注:最近更新在2025.03.08

月度归档: 2011 年 1 月

微软官方博客揭秘Kinect工作原理

你就是控制器(You are the controller)-如果你有在关注Kinect,相信已经听过这句给力的广告词了.从《Kinect Adventures!》中手脚并用堵漏水窟窿,到Zune播放界面中挥手换歌,Kinect开创了一种更加自然的娱乐交互方式.在这篇博客文章中,我将揭秘这款体感系统背后的秘密以及它如何让开发者创造Kinect体验.而Kinect团队的项目经理Arjun Dayal则将展示如何实现通过基于手势的方式来控制Xbox Dashboard和Kinect Hub.首先,让我们从指导Kinect研发的概念原理开始.

我们生活在一个模拟的世界

传统编程基于一系列的规则:原因和结果,非黑即白,非真即假.在为输入输出数目有限的简单系统建模时,这种方式工作得挺好.拿游戏《Halo》来说吧:按A键是让士官长跳,前拨左摇杆让他向前走,前拨右摇杆让他向上看.不是A,就是B.可惜的是,我们生活的真实世界并不是如此数字化,而是模拟的.

在模拟世界中,并不是只有简单的”是”和”否”,还有”也许是/否”;不仅有”对”和”错”,还有”对/错的可能性”.让我们想象一下挥手这一简单动作的所有可能性:身体运动的幅度,环境差异,衣服质地的不同,文化差异造成的动作差异等等.你可能需要研究10的23次方这么多的可能性,显然用传统编程方式来解决这类问题是不现实的.

我们从一开始就知道必须采用一种全新的,接近于人脑工作的方式来解决这一问题.当你遇到一个人的时候,你的大脑立即将注意力集中在他身上,并根据经验辨识出他的身份.这一过程并不是通过数百层的决策树来实现,人脑就是知道.婴儿很难区分出两个人的不同,但我们通过多年的学习和训练可以在几分之一秒内做到.事实上,你也许还能蛮准确地估摸出他们的年龄、性别、心情甚至个性.这也是让我们成就为人类的原因之一.

Kinect以类似的方法被创造出来.它观察身边的世界,它注意观察你的动作.即使Kinect从来没见过你挥过手,也能很快地从它学习过的TB级数据中猜测出你所做动作的含义.

Kinect传感器

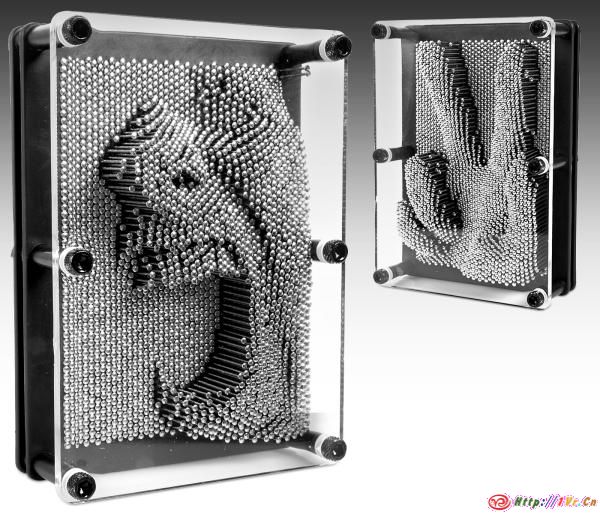

Kinect骨架追踪处理流程的核心是一个无论周围环境的光照条件如何,都可以让Kinect感知世界的CMOS红外传感器.该传感器通过黑白光谱的方式来感知环境:纯黑代表无穷远,纯白代表无穷近.黑白间的灰色地带对应物体到传感器的物理距离.它收集视野范围内的每一点,并形成一幅代表周围环境的景深图像.传感器以每秒30帧的速度生成景深图像流,实时3D地再现周围环境.如果你玩过pin point impression 3D针模玩具可能更容易理解这一技术——将你的手(或者脸,如果你愿意的话)按压在这种玩具上,就可以产生你身体某一部位的简单3D模型.

寻找移动部件

Kinect需要做的下一件事是寻找图像中较可能是人体的移动物体,就像人眼下意识地聚焦在移动物体上那样.接下来,Kinect会对景深图像进行像素级评估,来辨别人体的不同部位.同时,这一过程必须以优化的预处理来缩短响应时间.

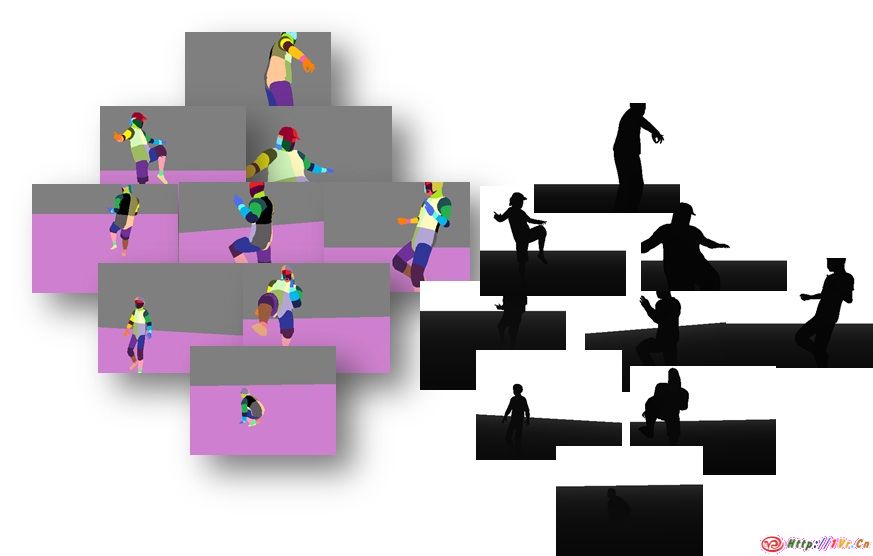

Kinect采用分割策略来将人体从背景环境中区分出来,即从噪音中提取出有用信号.Kinect可以主动追踪最多两个玩家的全身骨架,或者被动追踪最多四名玩家的形体和位置.在这一阶段,我们为每个被追踪的玩家在景深图像中创建了所谓的分割遮罩,这是一种将背景物体(比如椅子和宠物等)剔除后的景深图像.在后面的处理流程中仅仅传送分割遮罩的部分,以减轻体感计算量.

Kinect的大脑

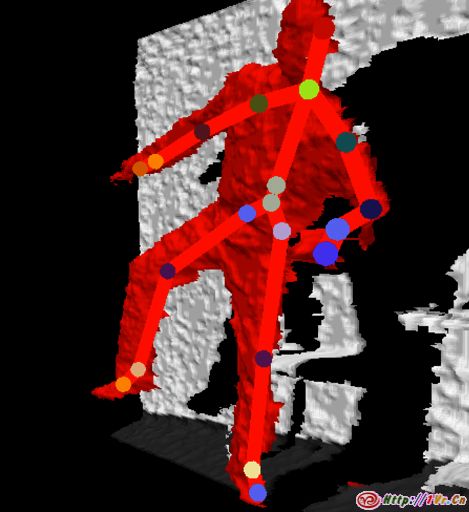

真正的魔术在这里发生.分割化玩家图像的每一个像素都被传送进一个辨别人体部位的机器学习系统中.随后该系统将给出了某个特定像素属于哪个身体部位的可能性.比如,一个像素有80%的几率属于脚,60%的几率属于腿,40%的几率属于胸部.看起来这时候我们就可以把几率最大的可能性当作结果,但这么做未免太过武断了.我们的做法是将所有的这些可能性输入到接下来的处理流程中并且等到最后阶段再做判断.

看了上面的介绍,你也许要问我们如何教会Kinect辨识人体部位.开发这一人工智能(被称为Exemplar(模型)系统)可不是一件轻松的事情:数以TB计的数据被输入到集群系统中来教会Kinect以像素级技术来辨认手、脚以及它看到的其他身体部位.下图就是我们用来训练和测试Exemplar的数据之一.

模型匹配:生成骨架系统

处理流程的最后一步是使用之前阶段输出的结果,根据追踪到的20个关节点来生成一幅骨架系统.Kinect会评估Exemplar输出的每一个可能的像素来确定关节点.通过这种方式Kinect能够基于充分的信息最准确地评估人体实际所处位置.另外我们在模型匹配阶段还做了一些附加输出滤镜来平滑输出以及处理闭塞关节等特殊事件.

骨架追踪系统的目标之一是为处理流程的各种输出提供一种菜单式的选择界面.游戏开发者可以选择任意的系统部件组合来开发各种游戏体验.比如,你可以仅仅使用分隔映射来制造一些惊人的华丽效果(《Your Shape: Fitness Evolved》是一个好例子).

讲到这里,我们已经描绘出一个可用于控制游戏或娱乐的完全实时的体感系统.接下来,Arjun将介绍改进的Xbox Dashboard和Kinect Hub.他将向你展示这两个用户界面如何利用景深图像流和20关节骨架系统来创造一种基于自然手势的,访问游戏、电影、音乐和其他娱乐活动的全新方式.

Kinect:技术如何最终理解你!

如今,技术在我们的日常生活中扮演着重要角色,但直到现在,技术产品在真正理解人类意图以及适应个体风格差异方面做得仍然不好.Kinect的问世让这一切有所改变.站在Kinect前,它就能知道你是谁.不仅如此,还能将你和你的爱人区别开来.当你移动时,传感器能在瞬间追踪到你.想要互动?用声音和肢体移动就可以播放电影、玩游戏、和朋友聊天等等.不需要学习任何新的控制方式,多么神奇!

前面Kinect团队项目经理Ron已经描述了Kinect传感器让Xbox实时追踪玩家动作背后的高深技术,但我们如何最佳地运用?我们的目标是让玩家尽可能自如地控制Xbox,同时让所有用户可以容易地学习并理解各种控制手势.接下来我们会更加深入地揭秘这一体感技术,并且谈谈在Kinect Hub和Dashboard中的Kinect体验.

手势:从何说起?

听到我们要设计一种手势来上下左右移动物体的时候,你也许会想:”没难度啊,把你的手移到物体上,选中然后向你想要的方向移动,搞定!”

等下,别那么自信.问问你的朋友他们是怎么想的,你可能会惊讶地发现他们的回答和你是如此的不同.是你的方式更好吗?不一定,只是对你来说更有逻辑性.人类的独特之处在于能通过多种方法来完成某一特定任务.让我们拿驾驶来做例子.如果你让100个人来模仿如何开车,你可能会得到许多答案.有些人会将两手分别握住面前的10点钟和2点钟位置,有些人可能会只用一手握住12点钟位置,有些人可能会背靠椅子坐着;同样地,模仿脚踩油门、刹车和离合器的方式也会五花八门.所有这些方式都能让我们驾驶,而技术的工作就是要能识别所有这些方式——让技术理解你!

那么,识别一个看似简单动作有多复杂呢,拿伸手做例子.当你想伸手去拿什么东西的时候,你会认为伸手的方向应该完全垂直于身体平面.但实际上由于肩膀和手臂关节的结合方式,你不可能以直线方式伸手.因此,每个人都会以略为不同的方式做出一个伸手动作,但每个人都觉得这是一个同样的伸手动作.成功的手势识别就是要理解人类动作的微妙之处,并且让技术了解这些不同.

研发Kinect这款革命性产品的过程中,我们既要战胜上述挑战还要让产品易于使用.我们所做的每个决定都是人机互动领域史无前例的,我们的工作有可能将重新定义互动娱乐技术的未来.

手势原型: 去粕取精

我们在为屏幕导航创造控制手势时,采用了很常见的方法:记录下了所有能想到的天马行空的点子,比如用脚来选择菜单神马的.当我们意识到这样的点子实在太多了的时候,我们知道需要一种更靠谱的选择方式.

我们收集并记录下所有创意,并且一一制作出原型以检验那一种更适合普通用户.和普通用户进行原型测试非常重要,我们因此学到了许多关于人体运动的信息,并用于重新调整每次新测试.人机互动的现有规则并不总是适用于在客厅进行的10英寸距离上的体感交互.通过测试我们更好地理解用户行为,比如长时间做手势时怎样才舒服,以及我们创造的控制手势集和人类自然手势是否冲突.

在测试过程中,我们的理念是”不断失败,去粕取精”,我们不断抛弃不合适的方案,保留有效方案.工程、用户研究和设计团队都充分参与到手势集的原型制作过程中,并和普通用户一起进行测试,根据所有获取到的数据来决定最佳手势.

在数月的测试、观察和研究后,我们得到了一种简单且容易理解的控制方式——悬停选择和翻页控制.悬停选择是一种容易学习、高度可靠并且可预测的机制,而翻页控制提供了一种更有触感的方式来控制屏幕内容.

让我们通过Xbox Dashboard和Kinect Hub的实现方式来更加深入地谈论这种控制模型的细节.

Kinect Hub: Kinect体验大本营!

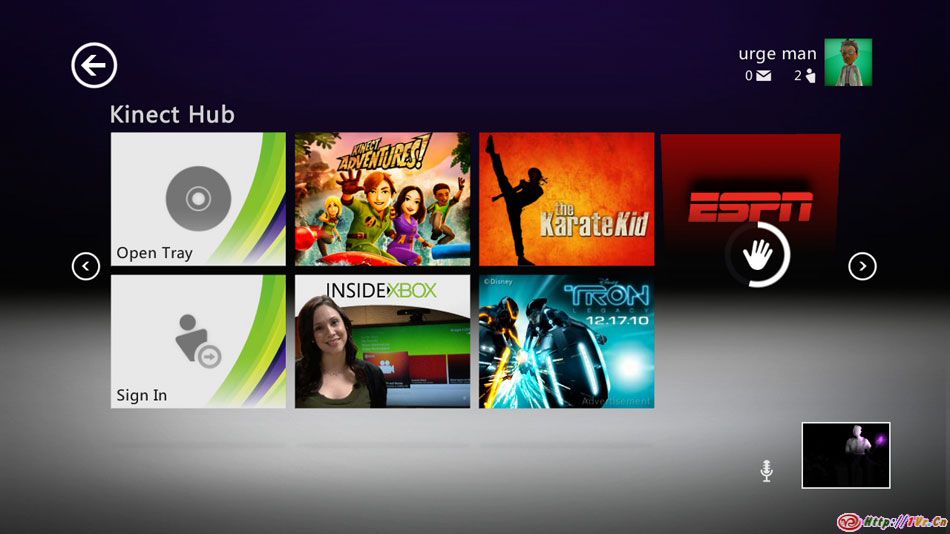

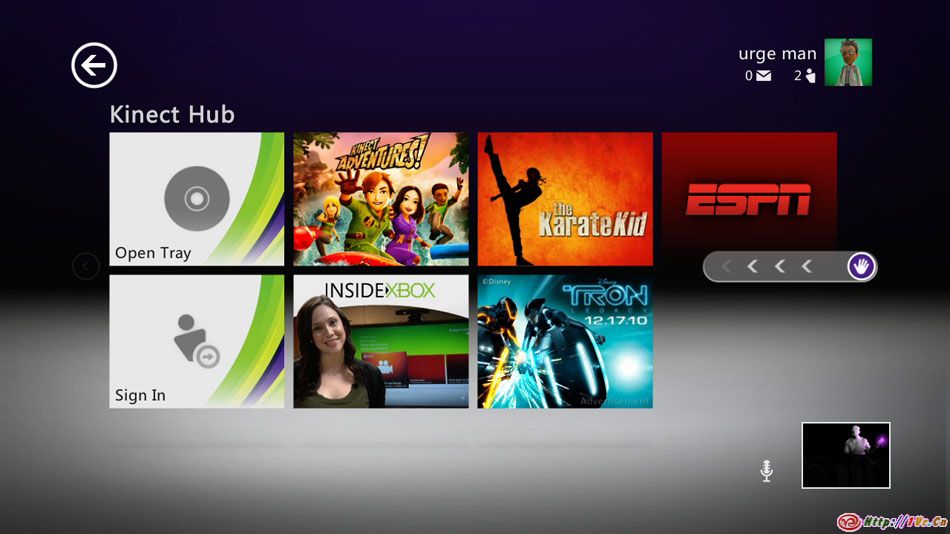

Kinect Hub是Xbox Dashboard中的Kinect体验中心,在这里你可以用手势来访问Kinect内容.Hub的设计简单且容易理解,你可以注意到我们采用了巨大的颜色分明的项目方块,让用户轻松地找到并选择他们所想做的事.

Kinect Hub: 如何使用?

可以通过悬停选择来轻易选中Kinect Hub中的任何项目.你所要做的就是将手停在想要选择的项目方块上并等待进度圆圈计时器填满.左右手都行!

我们为屏幕上的项目方块加入了一些有趣的立体效果,当你将手在项目方块间移动时可以注意到.(注意上图手掌光标所处的项目方块有略微向内翻开的效果)

如果你想看Hub中的其他东西,在屏幕左右两侧找到翻页图标.

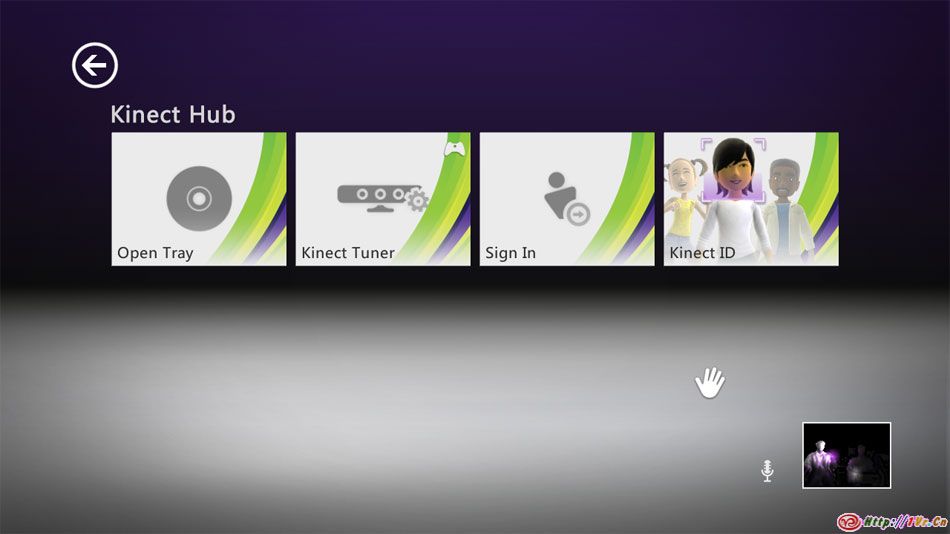

控制方法是将手移向翻页图标上,你会发现屏幕上的手掌光标被吸附过去,接下来你只需要按屏幕显示的方向拉动即可实现翻页.

Kinect Hub光标:如何知道谁在控制以及传感器看到了什么?

尽管同时只能有一个人控制Kinect Hub的手掌光标,但在我们收到的Beta测试反馈中有一个大问题是用户不知道谁在控制,也不知道Kinect是否能够真正看到他们正在做的动作.有些时候用户在Kinect前做动作,但却无法用手掌光标选中屏幕上的项目.还有一些时候,玩家不知道客厅的家具挡住了Kinect的视线,玩家必须对房间重新布局以改善效果.这些情况都将给用户带来极大的挫败感,因此我们决定给予用户更多的信息来解决这些问题.

我们的团队采用一种有趣的方式来解决这些问题,也就是Dashboard和Kinect Hub右下角的传感器视图功能.这一视图让用户看到实时景深视频,清楚地勾勒出玩家和房间内物体的轮廓.

当玩家挥手来控制屏幕光标的时候,你会注意到在景深视频窗口中该玩家的手会发亮,这一效果让玩家知道目前谁在控制Xbox.如果你想让旁边的人接管控制,可以让他前后挥手直至切换控制成功.

希望大家喜欢这篇揭示Kinect Hub以及体感工作原理的文章.开发这一全新的用户体验是一次奇妙之旅,看到用户开始使用这一未来的娱乐互动方式让我们激动万分.

原文:http://www.xbox.com/en-US/Live/EngineeringBlog/122910-HowYouBecometheController

转自:http://www.digg360.com/2011/01/how_you_become_the_controller/